WOE

what ?

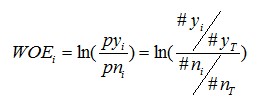

WOE的全称是“Weight of Evidence”,即证据权重。WOE是对原始自变量的一种编码形式。

对原始自变量编码的目的一般而言主要是用于提升模型的预测效果以及提高模型的可理解性。

要对一个变量进行WOE编码,需要首先把这个变量进行分组处理(也叫分栏、分箱)

举例说明:

表中以age年龄为某个自变量,由于年龄是连续型自变量,需要对其进行离散化处理,假设离散化分为5组,#bad和#good表示在这五组中违约用户和正常用户的数量分布,最后一列是woe值的计算,通过后面变化之后的公式可以看出,woe反映的是在自变量每个分组下违约用户对正常用户占比和总体中违约用户对正常用户占比之间的差异;从而可以直观的认为woe蕴含了自变量取值对于目标变量(违约概率)的影响。再加上woe计算形式与logistic回归中目标变量的logistic转换(logist_p=ln(p/1-p))如此相似,因而可以将自变量woe值替代原先的自变量值;

from :https://blog.csdn.net/goodhuajun/article/details/39582761

| Age | #bad | #good | Woe |

|---|---|---|---|

| 0-10 | 50 | 200 | LN((50/100)/(200/1000))=LN((50/200)/(100/1000)) |

| 10-18 | 20 | 200 | LN((20/100)/(200/1000))=LN((20/200)/(100/1000)) |

| 18-35 | 5 | 200 | LN((5/100)/(200/1000))=LN((5/200)/(100/1000)) |

| 35-50 | 15 | 200 | LN((15/100)/(200/1000))=LN((15/200)/(100/1000)) |

| 50以上 | 10 | 200 | LN((10/100)/(200/1000))=LN((10/200)/(100/1000)) |

| 汇总 | 100 | 1000 |

IV(Information Value)

what ?

概念

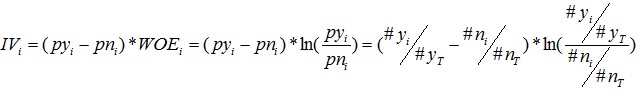

V是Information Value和缩写,即信息价值,或者信息量,是评分卡中用于挑选变量的一个衡量指标

用途

挑选变量的数据指标

例如在用逻辑回归、决策树等模型方法构建分类模型时,经常需要对自变量进行筛选。比如我们有200个候选自变量,通常情况下,不会直接把200个变量直接放到模型中去进行拟合训练,而是会用一些方法,从这200个自变量中挑选一些出来,放进模型,形成入模变量列表。那么我们怎么去挑选入模变量呢? 挑选入模变量过程是个比较复杂的过程,需要考虑的因素很多,比如:变量的预测能力,变量之间的相关性,变量的简单性(容易生成和使用),变量的强壮性(不容易被绕过),变量在业务上的可解释性(被挑战时可以解释的通)等等。但是,其中最主要和最直接的衡量标准是变量的预测能力。

“变量的预测能力”这个说法很笼统,很主观,非量化,在筛选变量的时候我们总不能说:“我觉得这个变量预测能力很强,所以他要进入模型”吧?我们需要一些具体的量化指标来衡量每自变量的预测能力,并根据这些量化指标的大小,来确定哪些变量进入模型。

IV就是这样一种指标,他可以用来衡量自变量的预测能力。类似的指标还有信息增益、基尼系数等等。

from 评分卡模型中的IV和WOE详解

How?(怎么用?)

计算公式:

IV依赖WOE,并且IV是一个很好的衡量自变量对目标变量影响程度的指标。但是,使用过程中应该注意一个问题:变量的任何分组中,不应该出现响应数=0或非响应数=0的情况。

具体可以参考CSDN上的一篇文章:评分卡模型中的IV和WOE详解